2016年の振り返りと、2017年の抱負とか。

2016年の総括

2016年は、本当に大変な年だった。おわり。

目次

- 体重キープした件

- 家出れるようになった件

- 君の名はまだ見てない件

- おうちハックしたい件

- 今年やった技術とか

- 今後の方向性とかに悩んでいる件

体重キープした件

大変素晴らしいことに、1年間体重を76kg前後にキープした。毎日体重を計測して、 Twitter のプロフィールに自動反映しているのが効を奏していると思う。オムロンのNFC体重計にスマホをぴっとやると、Twitter のAPIを叩いて変更する仕組み

家出れるようになった件

大変驚くべきことに、何もなくても家出れるようになった。これだけ書くと人間としてやばいっぽいが、休日家でごろごろマンは多いと思う。

引っ越したのが要因として大きい。徒歩圏内に、Wi-fiと電源のある、まあまあ入れるチェーン店のカフェが複数あるのが大事(スタバと上島珈琲店がある)。今後引っ越すとしても、繁華街の近くに引っ越すのが戦略として正しいっぽい。

君の名はまだ見てない件

シン・ゴジラは見たんだけど、まだ君の名はを見ていない。新宿の映画館とかでまだやっているそうなので、1月中に見に行きたいなと思う。

映画というところで言うと、2016年はギンレイホールに初めて行ってみた。ギンレイホールというのは、いわゆる「名画座」というジャンルの映画館。入れ替え制じゃないので、一回のチケットで2本映画を見られる。雰囲気のわりにはチョイスが古すぎるわけではなく、昨年アカデミー賞とかもやってる。

おうちハックしたい件

おうちハックというのは、家にIoT系の製品とか、Arduinoとかラズパイ取り入れたりする振る舞いのこと。おうちハックできなかったのは、2016年の目標の中で、ちょっと後悔しているものだったりする。

おうちハックに使えそうなものは結構揃ってて、

- Raspberry Pi 3 Model B

- IRKit

- milight とかいう Hue のパクリ製品

- ルンバ(リモコン付き)

- mornin という電動カーテン

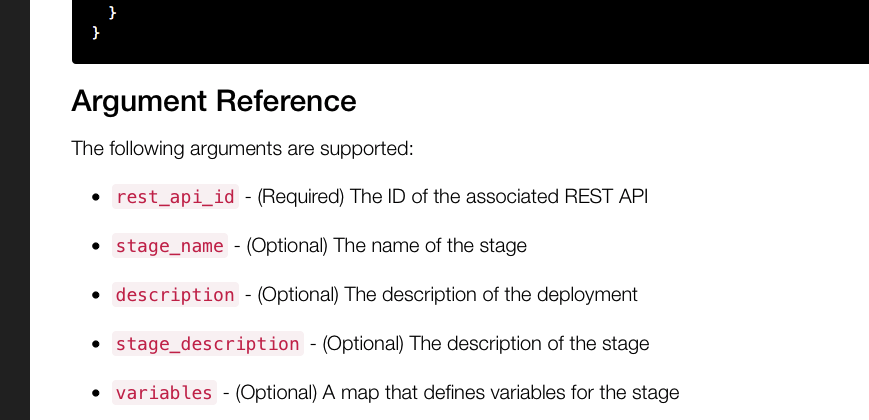

家に帰ったら、「おかえりなさい」って言いながら、やってないタスクとかを読み上げながら詰ってくるホームアシスタント作りたいなって思っている(もしかして:ジャーヴィス)。AWS に読み上げお姉さん API あるしね。

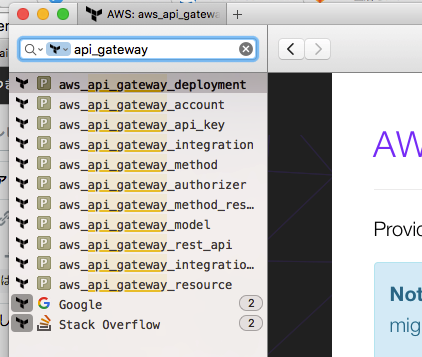

今年やった技術とか

だいたいこんな感じかも。Vue.js とkerasとGoは触りに近いかなorz

結果的には、Docker、Akka、Vue.js はかなり自分の役に立った。特に、プロトタイプ環境やデータ可視化環境を作るのに、Docker と Vue.js が大活躍していて、そのうちブログに書きたい。JSのReactiveなビューライブラリ界隈は、行き着くところはReactでもVue.jsでも(触ったこと無ないがRiot.jsでも)良いと思っていて、けど「手軽にさくっと」みたいな用途だと Vue.js が個人的に良かった。

Go は、本当に手に馴染まなくて辛かった。機会作ってまたやりたい。

機械学習周りは、今年あんまりできなかったなぁ・・・が、クリスマスに会社にGPUサーバーをお願いしたら予算がおりたので、頑張るぞい。GPU使う部でも作ろうかな。会社のデータ資産に機械学習をアプライするっていうところは、自分主導でいろいろと進めたいところ。

今後の方向性に悩む件

僕個人は、メインには技術をやりたいと思っている。特に機械学習周り(もっというとNLP)をビジネスに適用する、という分野に興味がある。これは、全くぶれていない。

唯一ぶれたのは、機械学習というものに対して、「キラキラ技術したいなあ」ではなく「ビジネスを真剣に考えて、課題解決をしたいなあ、あわよくばキラキラ state-of-the-art 良いなあ」という気持ちになったところ。つまりプライオリティが変わった。あと、「NLPって結局ルールベースが一番早いしメンテナブルやんけ!」みたいな諦めも若干あったりする(これを覆せないのは、完全に自分の経験不足に起因する)。

けど、PM的な立場についになってしまった。「なってしまった」というのは完全に言葉の綾で、どちらかといえば真面目にちゃんとマネジメントに取り組みたいし、そういう旨のことを経営陣に言って、そういう立場に置いてもらった、というのが説明として正しい。「自動化できる人間」たるエンジニア、そして「エンジニアの気持ちがわかる人間」たるエンジニアがマネジメントをするというのはとても大事なことで(私が人間の気持ちがわかるとは言っていない)、それは非エンジニアのマネジメントスペシャリストにはない視点。そういうところに問題意識を感じたりするので、「責任と裁量を持って、意見を述べたい」という旨のことを言ったのだった。

さて、ここにコンフリクトが発生する。「マネジメントに真剣に取り組みたい」も真だし、「機械学習のビジネス適用を真剣に取り組みたい」も真だけど、自分の体が一つしかない。

まあ、コンフリクトを解消する手法は単純で、残業とかもっと減らして(弊社、本来はホワイト企業なんだが、仕事脳なので一人ブラック企業している節がある)、周りを巻き込みながら勉強と実践する時間をもっと増やす、というのが正解っぽいし、これを今年一番の目標としたい。せっかくマネジメント側の機能を持つわけだしね、自分もチームも、残業なしに働けるように、頑張らないといけないね。

真人間になるための今年の目標

- 残業時間を減らす(週に5時間くらいにしたい)

- 週に5日は1〜2時までに寝る生活習慣を作る

- 会社のGPUを活用する部を作る

- ホームアシスタントを作る

- 今年二回は旅行に行く。一回は一人旅をする。

- 月に一回は映画館で映画を見る

- 休日コンスタントに12時ぐらいに家出れるようになる

- 体重をキープする

- 週一程度で弁当を作る

振り返ってみたけど、1年というのは振り返るには長すぎるかもしれない。半年ぐらいで振り返りたい。